- 動画とライブのまめ知識

そもそも「動画」ってなんだっけ?(前編)

知っておいて損はない、ライブ配信・動画配信の専門家も思わず唸る、「動画」そのものについて解説します。

1. そもそも「動画」とは何か?

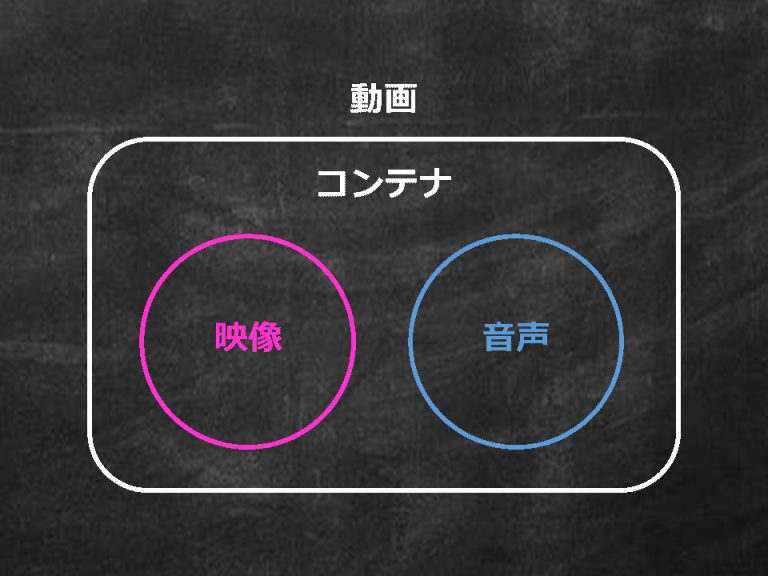

動画とは、一般に、別々のデータである「映像」と「音声」を「コンテナ」と呼ばれる入れ物にまとめて格納したデータを指します。

実際に、パソコン・スマートフォン向けの動画配信サービスのほとんどで、この形式が利用されています。

「コンテナって、あの物流に使われている箱のこと?」なんてお声が聞こえて来そうですが、例えば、別々のデータである映像と音声をズレなく再生するためにも、コンテナは利用されています。

今回は、「映像」「音声」「コンテナ」の観点から「動画」の構造や仕組みを解説します。

2. 「映像」とは?

映像は、「ビデオフレーム」と呼ばれる1枚1枚の静止画像が集まって構成されています。

複数のビデオフレームを時系列順にパラパラ漫画のように表示すると、画に動きが出て映像になります。

そして、映像の1秒間あたりに表示されるビデオフレームの数を「フレームレート」と呼びます。

では、仮に1時間の映像があるとして、一体どのくらいのデータサイズなのか想像はつきますでしょうか?

今回は細かい説明は省略しますが、簡単に計算してみたいと思います。

・1画素のサイズ:3byte(※)

・フレームレート:30fps

・映像尺:1時間(3,600秒)

※ 一般的な画像では、RGBと呼ばれる赤・緑・青の三原色を合わせることで、さまざまな色合いの表現を可能にします。それぞれの原色は8bitのデータサイズで構成されるため、その3倍の色で表現される1画素のデータサイズは24bitとなります。そして、1byte=8bitで変換されるため、ここでは1画素のサイズを3byteとしています。これは、映像や画像の処理でよく使われるYUVフォーマットでは「4:4:4」に該当します。

921,600(画素) × 3(byte) × 30(fps) × 3,600(秒) = 約278GB

また、「ビットレート」と呼ばれる1秒間当たりのデータサイズは以下のようになります。

・ビットレート

約278(GB) ÷ 3,600(秒) = 633Mbps

これらの数値を身近な対象と比較すると、データサイズは、Appleから発売されているiPhone 11のハイエンドモデルの容量以上の大きさになります。

しかも音声がついていない映像のみのデータサイズです。

読者の皆さんは、普段から 278GB ほどのデータを取り扱っていますでしょうか?

また、上記計算の結果得られるビットレート 633Mbps は、一般的なインターネット回線でNetflixのHD画質の動画を視聴する場合の推奨値 5Mbps と大きく乖離しており、これではとてもではありませんがパソコン・スマートフォンで映像を楽しめそうにありません。

そこで登場するのが映像の「圧縮技術」という、動画配信に欠かせない存在です。

映像の「圧縮技術」とは?

このコーデックこそが映像の「圧縮技術」の正体であり、有名なところでは、DVDや地デジなどで利用されるMPEG-2、Blu-rayや多くの動画配信サービスで利用されるH.264/MPEG-4 AVCなどが挙げられます。

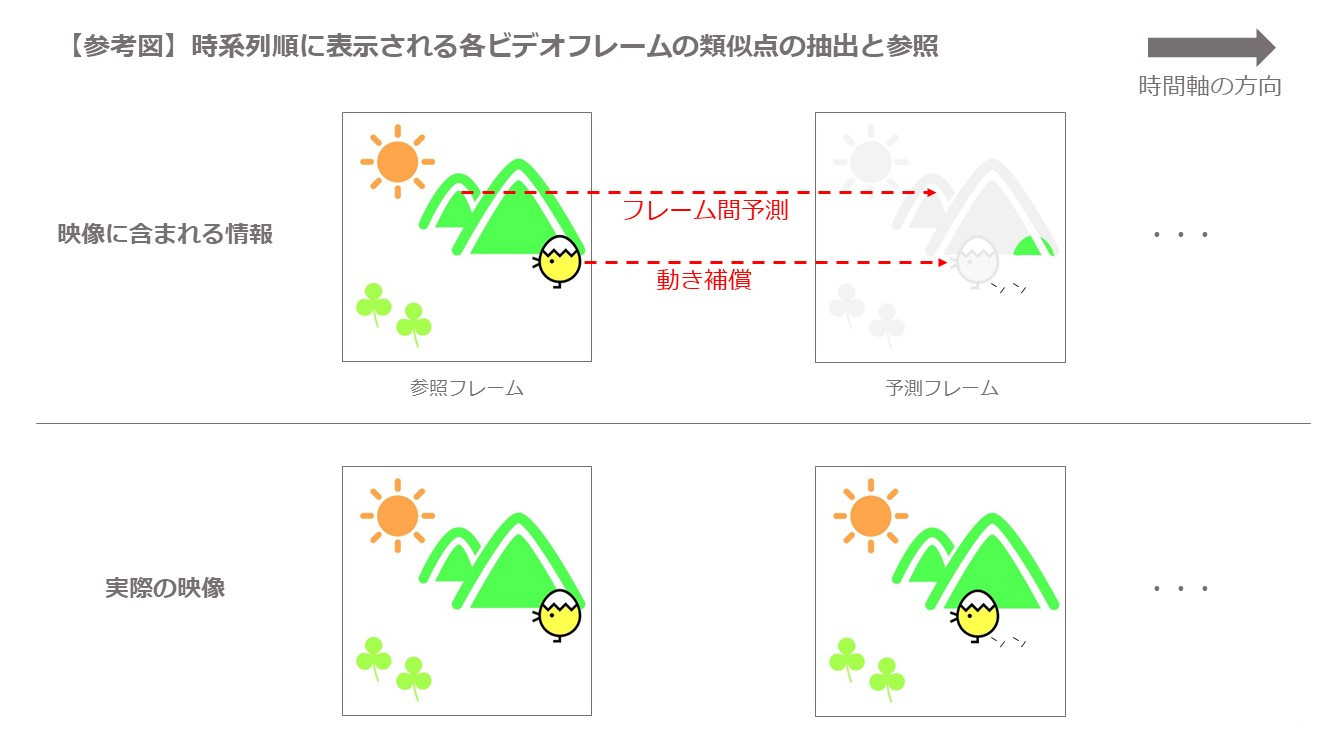

コーデックは、人の視覚では認識されにくいビデオフレーム内の細部の省略や時系列順に表示される各ビデオフレームの類似点の抽出と参照等、映像に含まれる情報を効率的に削減するための特有の仕組みを取り入れることで、単純な算術的圧縮技術に比べて、大幅なデータサイズの圧縮を可能にします。

前出のNetflixの推奨ビットレートが 5Mbps であることを例にとると、映像の圧縮技術により、ビットレートが 633Mbps から 5Mbps 以下、つまり1/100以下にまで圧縮されていることが分かります。

それに伴い、データサイズも 約278GB から 約2~3GB 程度にまで圧縮されます。

このデータサイズも決して小さくはありませんが、多くの動画配信サービスにおいてはより低いビットレートで配信されることがほとんどで、その分データサイズもさらに小さくなります。

これならば、一般的なインターネット回線とパソコン・スマートフォンでも十分に映像を楽しめますね。

一方、過度な細部の省略等により、圧縮された映像に品質の劣化が見られる場合もあります。

このような劣化は「デジタルノイズ」と呼ばれ、読者の皆さんも一度は目にしたことがあるのではないでしょうか。

代表的なものでは、映像がモザイク状のブロックに分割されたような見た目になる「ブロックノイズ」、映像内の物体の輪郭部分にたくさんの蚊がたかっているような見た目になる「モスキートノイズ」、本来滑らかなグラデーション部分が段階的な色の帯のような見た目になる「バンディングノイズ」などがあります。

3. 圧縮映像は意外と身近にある!

前編では、「映像」「音声」「コンテナ」といった「動画」の構成要素とその一つである映像に関する圧縮技術について解説し、動画配信には「コーデックにより圧縮された映像」が使用されていることもお伝えしました。

技術的な話を受けて難しい印象をお持ちになった方もいらっしゃるかもしれませんが、映像の「圧縮技術」は動画配信だけではなく、ご紹介した通り、読者の皆さんが普段目にしている地デジやBlu-rayにも利用されています。

昨今、4K映像をご覧になる機会も増えているかと思いますが、このより精細な高画質の映像を楽しめるようになった背景にも、新しいコーデック H.265/HEVC の登場や対応機器の普及など、映像の「圧縮技術」の進歩があります。

目には見えませんが、圧縮映像は意外と身近な存在ということですね。

動画配信の豆知識として、ぜひお役立ていただければと思います。

▼後編はこちら

当社担当者から折り返しご連絡いたします。

スタジオのロケハンや仮予約なども無料で承ります。

- スタジオご利用のお客様への新しいサービスとして、撮影・配信に必要な機材を個別レンタルできるオプションプランをスタートしました。- 2025年8月15日 -

- 2025年4月12日(土)16時より、参加型イベント『ボーイズグループ対抗 春の体力まつり』を開催!- 2025年3月24日 -

- 2025年1月19日(日)19時より、PLAY STUDIOオリジナルバラエティ番組『緑仙&弦月 Vの部屋』のライブ配信が決定!- 2024年12月16日 -

- 撮影/配信スタジオのご利用料金を改定しました。- 2024年10月1日 -

- 早割基本料金20%OFFキャンペーン!10月1日以降のご利用で機材付きプラン/おまかせプラン/収録・配信パッケージをお得にご利用いただけます。- 2024年7月5日 -

- 企業の動画制作をトータルサポートする「収録パッケージ」と「配信パッケージ」の提供を開始しました。 - 2024年3月26日 -

- 基本料金10%OFFキャンペーン!2024年4月と5月の期間限定で撮影/配信スタジオがお得にご利用いただけます。 - 2024年3月19日 -

- ハウススタジオ風撮影スペースでフォト/スチール撮影にご利用いただける「機材オプション」と「フォトスタジオオプション」の販売を開始しました。 - 2024年3月8日 -

- 配信イベントのプロデュースやインタラクティブなライブ配信プラットフォーム「LIVEPARK STUDIO」のサービス提供が可能になりました。是非ご利用をご検討ください。 - 2023年7月7日 -

- PLAY STUDIOの運営会社が変わりました。今後もより良いサービスの提供に努めてまいります。 - 2023年6月1日 -